AI Teammate, Gemini Pro 1.5, Project Astra: Le récap de la keynote de Google sur l'IA

La Google I/O 2024 s'est tenue le 14 mai et a été marquée par plusieurs nouveautés sur l'IA. Qu'il s'agisse d'AI Teammate, de Gemini Pro 1.5 ou encore du Project Astra, Google a fait des annonces prometteuses sur l'avenir de l'IA sur nos smartphones et surtout notre travail au quotidien. nextpit a suivi l'événement pour vous et vous propose donc un récap complet des principales annonces.

Open AI a tenté lundi soir de couper l'herbe sous le pied de Google en présentant son nouveau modèle GPT-4o. La dernière version de ChatGPT est censée traiter non seulement du texte, mais aussi des conversations transparentes, reconnaître les émotions et traiter les entrées via la vidéo en direct. Hier, Google a contre-attaqué lors de la Google I/O 2024 avec une IA futuriste à grande échelle. On vous en explique tout.

Quelle est la force du modèle d'IA de Google?

Gemini est à Google ce que ChatGPT est à OpenAI. Et au moins au jeu du quatuor, le modèle d'IA le plus puissant de Google, appelé Gemini Pro 1.5, devance largement les modèles GPT-4 actuels.

Selon Google, Gemini Pro 1.5 peut en effet traiter 1 million de jetons, alors que les divers modèles GPT-4 ne peuvent en traiter que 128 000. Ce nombre de jetons fait référence à la quantité d'informations que le modèle en question peut contenir pour la tâche en cours.

Cependant, ces chiffres ne font pas tout. Cela dépend également de l'efficacité avec laquelle les informations peuvent être traitées, par exemple l'efficacité avec laquelle les informations sont extraites des vidéos et mises à disposition pour un traitement ultérieur.

Selon Google, avoir 1 million de jetons permet de capturer 1500 pages PDF, 30.000 lignes de code ou une heure de vidéo, par exemple. Google prévoit de mettre prochainement à la disposition de développeurs sélectionnés un modèle Gemini de 2 millions de jetons dans différents environnements de développement. Et le président d'Alphabet, Sundar Pichai, proclame un objectif clair : "Infinite Context", c'est-à-dire une mémoire quasi totale pour les modèles d'IA.

Quels produits Google auront de nouvelles fonctionnalités d'IA?

Voilà pour la théorie. Mais qu'est-ce qui va changer dans les différents services Google? Lors de la Google I/O, quelques annonces concrètes ont été faites, dont certaines prendront effet dès maintenant.

D'autres produits ont été annoncés avec des dates de sortie plutôt imprécises du type "dans les prochains mois", et il n'est souvent pas clair non plus si le déploiement des fonctionnalités d'IA s'appliquera au marché mondial ou seulement aux États-Unis dans un premier temps.

Par ailleurs, Google a également son service payant Gemini Advanced. Par exemple, ceux qui ont souscrit à l'offre IA Premium du service Google One pour 22 euros par mois obtiendront certaines des fonctionnalités plus tôt ou avant tout le monde. Par exemple, l'accès à Gemini Pro 1.5 en 35 langues est disponible dès maintenant et l'extension à 2 millions de jetons sera disponible "plus tard cette année".

En bref, le portefeuille d'IA de Google est un patchwork confus, et je crains que cela ne change pas de sitôt. Alors, voyons en détail ce qu'il en est!

- Lisez aussi notre premier test du Google Pixel 8a

Google Workspace: L'IA s'imisse dans notre travail quotidien

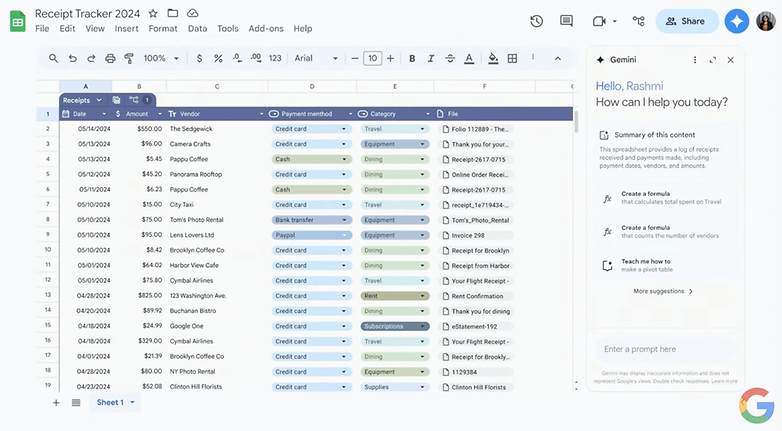

Google Workspace est un large bouquet d'applications bureautiques, de Google Sheets à Gmail en passant par Google Slides. L'année dernière, lors de la Google I/O, nous avions déjà eu droit à la présentation de l'assistant Gemini, qui devait écrire des textes et bricoler des tableaux intelligents remplis de formules ou de présentations.

Les comptes Google anglophones ont déjà pu utiliser ces fonctions avec Gemini Advanced, et à partir du mois prochain, le soi-disant Side Panel devrait être disponible pour tous. Est-ce que cela concerne les différentes langues ou les utilisateurs non payants? Cela n'a pas été précisé.

Ce qui est cool, c'est qu'à l'avenir, il sera possible de parler à Gmail de manière globale. Si vous avez reçu différentes offres d'artisans, l'intelligence artificielle recherchera les différentes conditions et les périodes possibles, les résumera et vous amènera directement au bon endroit en appuyant sur un bouton pour poser des questions ou pour accepter ou refuser directement. Cette fonctionnalité spéciale devrait d'ailleurs être disponible pour tous les utilisateurs à partir de "juillet".

Ce qui est aussi intéressant dans Google Workspace, c'est que les fonctions d'IA fonctionneront à l'avenir sur différents outils. Lors de la keynote, nous avons eu l'exemple d'une photographe indépendante dont la boîte aux lettres électronique déborde de messages non lus contenant des factures.

Dans le side panel, la proposition est arrivé directement: créer un répertoire Google Drive avec cette facture et 37 autres, ainsi qu'une feuille de calcul avec un aperçu et une classification des factures. Ce qui est cool c'est qu'après accord, cette opération ne s'execute pas une seule fois, mais directement créée en tant qu'automatisation.

Ces automatisations multi-plateformes n'arriveront toutefois pas avec le Side Panel, mais en septembre et pour l'instant uniquement aux utilisateurs Labs, donc quasiment aux bêta-testeurs.

2025 apportera des changements plus importants

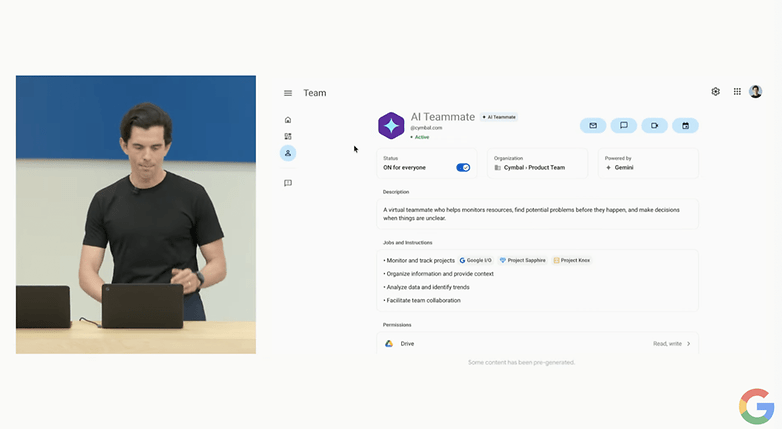

Google a également fait quelques annonces pour l'année prochaine. Ainsi, il sera possible à l'avenir d'ajouter des Collègues IA ou AI Teammate aux comptes d'entreprise avec le titre du poste, le statut, l'unité d'équipe et bien sûr le nom. Vous pourrez ensuite ajouter ces Collègue IA dans Google Chats, les partager dans les répertoires Drive, les mettre en copie dans les e-mails, etc.

Et vous pourrez ensuite leur donner des tâches en fonction des informations disponibles. À la question "Sommes-nous en bonne voie pour le lancement de notre produit?", l'AI Teammate crée une chronologie et met directement en évidence les problèmes potentiels. Google promet également un support 3rd-Party permettant aux entreprises de préconfigurer certains types de Collègues IA.

Project Astra et agents d'IA personnels

En dehors de Google Workspace, vous devriez également avoir vos propres Collègues IA, comme des assistants personnels. Il s'agit de ce que l'on appelle des "agents". Dans ce contexte, ce terme signifie qu'un modèle d'IA peut élaborer une stratégie logique et agir selon un plan déterminé.

Par exemple, vous pourrez dire: "Je veux renvoyer les chaussures que j'ai achetées en ligne hier". Ensuite, un agent recherchera dans vos e-mails la facture correspondante, déclenchera un renvoi via la boutique en ligne concernée et vous montrera directement l'étiquette de renvoi.

La démonstration du Project Astra était encore plus spectaculaire: selon Google, elle a été filmée en temps réel et sans coupures sur un smartphone.

Dans un bureau, la caméra a d'abord cherché des objets qui font du bruit, expliqué un composant d'un haut-parleur, généré une allitération pour une collection de stylos, expliqué la méthode de cryptage utilisée dans le code affiché sur l'écran de l'ordinateur et reconnu le quartier londonien dans lequel se trouve le bureau en regardant par la fenêtre.

Le plus intéressant c'est qu'à la suite de la vidéo avec de nombreux panoramas, l'IA a également pu répondre à la question de savoir où les lunettes avaient été déposées.

En parlant de lunettes, "imaginez cela avec des lunettes connectées", a lancé au public Demis Hassabis, le fondateur de Deepmind, qui a eu l'honneur de faire cette partie de la présentation.

La recherche Google boostée par l'IA

Google a commencé à déployer aux Etats-Unis toute une série de nouvelles fonctionnalités pour Google Search et d'ici fin 2024, ces fonctionnalités devraient être disponibles pour plus d'un milliard d'utilisateurs.

Au cœur de la nouvelle recherche Google se trouvent les AI Overviews, qui rappellent fortement l'application Perplexity. Google y résume certaines informations autour d'un thème sur un écran dynamique et affiche des liens vers les sources correspondantes.

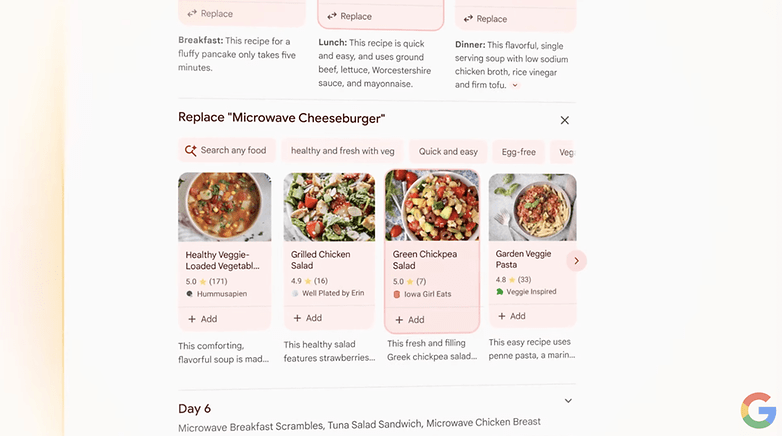

Par exemple, si vous recherchez un régime alimentaire, l'application vous présentera un régime hebdomadaire avec différentes recettes et des liens vers d'autres informations. Si une recette ne convient pas, elle pourra être rapidement remplacée en un clic. Pour des commentaires plus complexes, il y a un champ de texte pour saisir des messages d'encouragement du type "Intégrez plus d'options végétariennes".

Il est important de noter que la recherche Google devra toujours comprendre le contexte. En plus des recettes, ces AI Overviews devraient également contenir des conseils de restaurants au début, puis des soirées, des rendez-vous, des plans d'entraînement, des voyages, du shopping et bien plus encore.

Une autre particularité de la nouvelle recherche Google est qu'elle permettra de décrire directement des situations complexes. Ainsi, vous n'aurez pas besoin de demander un régime alimentaire, mais vous pourrez directement indiquer que les repas doivent être préparés rapidement et uniquement avec un four à micro-ondes.

La recherche multimodale avec vidéos

À l'avenir, il sera également possible d'effectuer des recherches non seulement en tapant du texte, mais aussi via une vidéo et par la voix. Lors de la keynote d'ouverture, un exemple frappant a été donné sur scène. Rose Yao a filmé un tourne-disque dont le bras de lecture revenait toujours en position de stationnement.

En réponse à la question "Quel est le problème?", la recherche Google a identifié le modèle de tourne-disque et le problème, et a pu renvoyer directement à des pages web proposant des solutions. La date de déploiement de cette recherche multimodale par vidéo et voix reste toutefois un mystère.

Android 15 fera le plein d'IA

Quelque part au milieu des 121 mentions du mot "IA", Google a également brièvement parlé d'Android 15. Mais là encore, surprise, l'accent a été mis sur les questions d'IA. Des fonctionnalités d'IA déjà connues, comme Circle to Search, devraient être disponibles sur 200 millions d'appareils Android d'ici fin 2024.

Par ailleurs, Google veut remplacer Google Assistant par Gemini et vous pourrez alors entrer et sortir directement du texte, de la voix, des images et des vidéos. Pour cela, Google promet également une version multimodale de Gemini Nano.

Cette version de Gemini fonctionne en local et est donc particulièrement adaptée aux contenus sensibles. Elle devrait être disponible plus tard dans l'année sur les smartphones Pixel et pourrait, par exemple, détecter les appels frauduleux ou expliquer le contenu de l'écran aux aveugles.

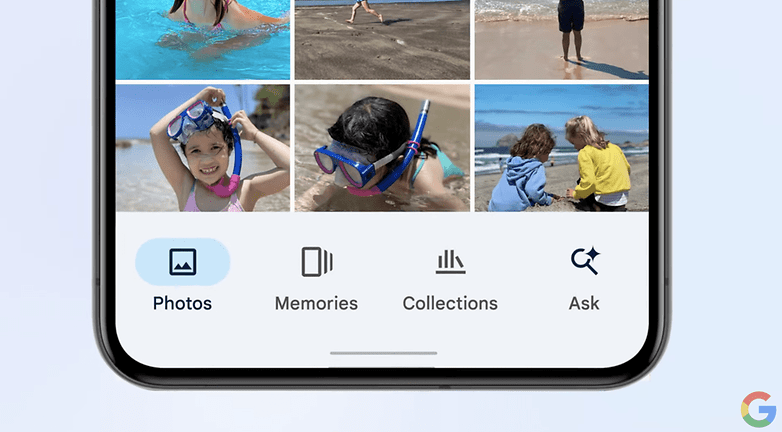

Google Photos devrait également être doté de nouvelles fonctionnalités d'IA. Par exemple, avec Ask Photos, vous pourrez, à un moment donné "à partir de cet été", parler à votre collection de photos et demander, par exemple, "Quelle était la plaque d'immatriculation de ma voiture ?" L'IA devinera alors quelle voiture vous appartient probablement et vous présentera une photo de la plaque d'immatriculation.

Un autre exemple de la présentation était la question: "Quand ma fille a-t-elle appris à nager?" Une série de photos montrant les progrès de la fille en matière de natation a pu être générée directement par commande.

De plus, une application Gemini arrivera sur Android qui, comme le modèle OpenAI GPT-4o présenté récemment, devrait également permettre des conversations naturelles. Et oui, là aussi, il devrait être possible d'interrompre l'IA en train de parler si la conversation prend une mauvaise direction.

Il paraît qu'une adaptation aux modèles de langage de l'utilisateur rendrait les conversations particulièrement humaines. Là encore, Google nous renvoie à l'été.

La bêta 2 d'Android 15, disponible à partir du 15 mai, contiendra-t-elle déjà de nouvelles fonctionnalités d'IA? Nous allons l'essayer pour en avoir le cœur net.

La créativité de l'IA, de la vidéo à la musique

Bien entendu, divers outils de création basés sur l' IA ont été mentionnés. Après tout, que serait une keynote axée sur l'IA d'un géant d'internet sans images de chats?

- Music AI Sandbox a pour but de donner aux artistes de nouveaux outils créatifs. Wyclef Jean, par exemple, s'est montré enthousiaste à l'idée d'appliquer des styles musicaux à des morceaux existants, et le roi du remix Marc Rebillet a apprécié que son collègue IA remplisse des boucles vides et lui donne des idées intéressantes

- Avec Imagen 3, vous pourrez à l'avenir générer des images de chats encore plus réalistes. Les invites devraient être comprises de manière encore plus précise et la génération de textes, par exemple pour les logos, devrait également fonctionner de manière fiable. Les utilisateurs intéressés peuvent postuler dès aujourd'hui sur labs.google pour cette fonctionnalité d'ImageFX

- Bien sûr, la génération de vidéos a également été abordée. Le modèle d'IA Veo permet de générer des vidéos 1080p dans de nombreux styles cinématographiques à partir de textes, de photos et de vidéos. Le cinéaste Donald Glover est en train de "tourner" un court-métrage mais là encore, Google n'a pas donné de date précise

- Dans l'application expérimentale Notebook-LM, il sera possible à l'avenir de générer des dialogues entre deux IA sur la base des informations qui y sont déposées. Lors de la keynote, une démonstration a montré deux personnes en train de discuter des lois de Newton, et ce par la voix. Grâce au bouton "Join", il était possible à tout moment de rejoindre la conversation et de l'orienter dans la direction de son choix, de sorte que la discussion physique un peu aride explique ensuite les bases de la physique à l'aide de l'exemple du "basket-ball".

Google vs OpenAI: Qui gagnera la bataille de l'IA?

Qui a la meilleure IA: Google ou OpenAI? Sans avoir testé Gemini Pro 1.5 ou les aspects multimodaux de GPT-4o, il est difficile de le dire. Mais une chose est claire: OpenAI dispose d'un ensemble de modèles linguistiques, d'une application pour smartphone et maintenant d'une application pour ordinateur de bureau et bien sûr, dune 'API.

Quant à Google, en plus de ses modèles d'IA, la société exploite par exemple Google et YouTube, les deux sites web les plus visités avec 275 milliards de visites mensuelles, la suite bureautique la plus utilisée au monde avec trois milliards d'installations ou encore l'OS mobile le plus utilisé au monde avec 71% de parts de marché. Google aura donc, contrairement à OpenAI, beaucoup moins d'obstacles pour amener ses modèles là où se trouvent les cas d'utilisation.

A moins que le 10 juin, les rumeurs ne se confirment et que le grand concurrent de Google n'annonce un partenariat avec OpenAI lors de sa propre conférence des développeurs. Nous le saurons dans moins d'un mois, à la WWDC d'Apple avec, espérons-le, des horizons plus clairs.