L'IA signifiera-t-elle la fin de la responsabilité personnelle ?

Il n’y a pas si longtemps, l’intelligence artificielle était l’apanage de la science-fiction et des recherches théoriques, avant de commencer à fonctionner en arrière-plan dans un certain nombre de services en ligne. Aujourd’hui, nous commençons à voir apparaître des appareils reposant sur des intelligences artificielles un peu partout sur le marché. Alors que nous déléguons une part toujours plus grande de notre vie quotidienne aux algorithmes, l’idée de responsabilité personnelle est-elle toujours pertinente ?

Les effets de la technologie sur la culture et la société peuvent être subtils. Lorsqu’on nous propose un nouveau jouet ou service qui rend nos vies plus faciles, nous finissons généralement par l’adopter et par l’utiliser sans y penser, et sans considérer les conséquences qui peuvent apparaître des années après.

La vie privée a été la première victime

Prenons la protection des données personnelles, par exemple. Lorsque Facebook a été chaviré par le scandale de Cambridge Analytica, il a fait la une de l’actualité. Mais ce qui m’a le plus surpris a été la réaction d’une grande partie du grand public : une totale indifférence.

Pourquoi donc les gens réagissent-ils si peu ? Il s’agit pourtant d’une fuite massive de nos données personnelles. Ne devrions-nous pas nous indigner d’une telle manipulation de nos données par les publicitaires et les politiques ?

C’est peut-être parce que les procédés techniques derrière ces scandales sont trop complexes pour que la majorité des individus saisissent leur déroulement exact. Le contrat d’utilisateur final pour les différents services qu’une personne peut utiliser sont eux-mêmes denses et opaques, et nous n’avons généralement pas le temps de le lire (et encore moins de l’étudier en détail). Une étude a d’ailleurs montré que pour lire toutes les déclarations de protection des données des services que nous utilisons, nous aurions besoin d’un mois de congé chaque année.

Pourtant, la plupart d’entre nous continue d’accepter ce pacte faustien, et d’abandonner notre droit à la vie privée parce que Facebook ou Google (parmi bien d’autres) sont trop pratiques pour nous au quotidien. Sans compter que nos amis (ou compétiteurs pour les entreprises) l’utilisent, et qui a envie d’être laissé de côté ?

On peut continuer à se demander comment on en est arrivé là, mais les faits demeurent : la vie privée n’est plus en 2018 ce qu’elle a été par le passé. Les attentes sont différentes, une grande partie des individus étant près à donner à des sociétés des informations qu’il aurait été choquant de partager il y a quelques décennies. C’est le prix à payer en entrant dans le monde de la technologie, et nous sommes généralement d’accord pour nous y résoudre.

On a beau inciter les gens à utiliser des VPN et à chatter sur Signal, le virage a déjà été pris dans la tête d’une partie des utilisateurs : la protection de la vie privée n’est pas un si grand problème. En tout cas pas suffisant pour leur donner envie de changer les choses.

L’IA rend la responsabilité individuelle secondaire

Les récits d’intelligences artificielles devenant conscientes et se retournant contre l’humanité sont légion. Mais un autre risque existe, et il est peut-être plus réaliste. Comme tous les outils, l’IA permet de rendre une tâche plus simple, de l’accomplir de manière plus efficace. Mais plus l’outil s’éloigne d’une main humaine pour le guider, plus la question de la responsabilité individuelle devient floue.

La vie privée est une chose, mais la question de la responsabilité peut prendre une autre ampleur s’il s’agit d’une question de vie ou de mort. Lorsqu’un appareil ou service guidé par une IA fait une erreur qui a des conséquences, qui en est responsable ? Les ingénieurs informaticiens, même si la machine a « appris » ses méthodes sans eux ? La personne qui a appuyé sur le bouton « on » ? L’utilisateur qui a consenti à l’utilisation d’un service sans en lire les conditions ?

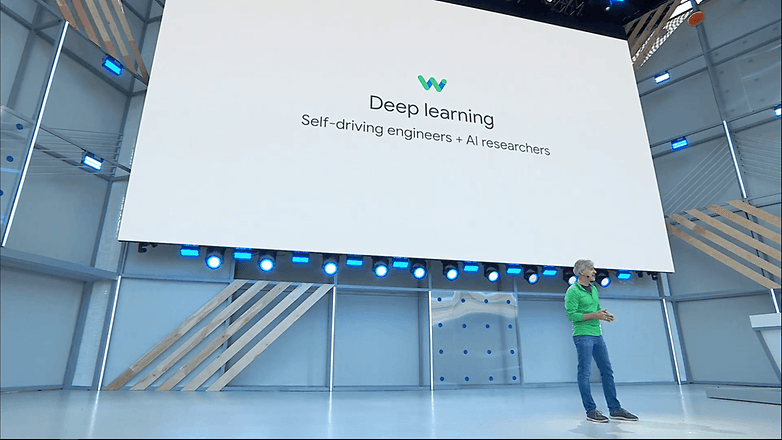

Les voitures autonomes sont au cœur de ce dilemme. Par exemple, une voiture autonome développée par Nvidia apprend à conduire grâce à un système de deep learning servant à collecter les données de conducteurs humains. La technologie est par ailleurs excellente : elle sait rester dans sa voie, prendre des virages, reconnaître des panneaux, etc.

Très bien, rien à redire tant que la voiture fait ce qu’on lui demande. Mais que se passera-t-il sur une voiture autonome décide de tourner soudainement en direction d’un mur ou d’un lac ? Et si la voiture dévie brutalement de sa route pour éviter un piéton, mais tue son passager ? La voiture devra-t-elle comparaître devant un tribunal ?

Dans l’état actuel des choses, il pourrait être impossible de découvrir pourquoi ou comment les accidents arrivent, étant donné que l’IA ne peut pas nous expliquer ses choix et que même les ingénieurs qui la paramètrent ne pourront pas suivre tous les processus en cours guidant chaque décision. Pourtant, il est probable que l’on demande un responsable. Ce problème fait partie des principales raisons qui empêchent pour le moment les voitures autonomes d’être commercialisées auprès du grand public. A moins qu’il ne soit finalement décidé de mettre cette technologie innovante sur le marché au vu des profits potentiels, et de se poser les questions ensuite.

Imaginer une IA impliquée dans un accident de voiture est un exemple dramatique, mais d’autres aspects de notre vie pourraient donner des responsabilités à la machine. L’IA pourrait diagnostiquer nos maladies, et « décider » la vie ou la mort d’un individu. Elle pourrait faire des choix de transaction financière a plusieurs millions de dollars, ou des choix tactiques sur une zone de guerre. Un problème de ce genre s’est déjà posé, avec des asthmatiques diagnostiqués à tort comme « risque faible » par une IA programmée pour détecter les pneumonies.

Vu que les IA sont de plus en plus avancées, elles prendront probablement les bonnes décisions… 99,9% du temps. Et peut-être que pour les 0,01% restants, nous nous résignerons comme nous le faisons avec le scandale des données personnelles de Facebook.

Les assistants et les applications auront plus de responsabilités

Intéressons-nous aux processus à l’œuvre. Lors de la Google I/O, Google a montré quelques domaines dans lesquels l’IA pouvait nous rendre la vie plus facile. Les assistants virtuels sont de plus en plus utilisés depuis quelques années, et prennent de plus en plus de place dans l’espace domestique d’un grand nombre de familles. La démo Google Duplex montrait comment déléguer à un assistant les réservations, lui demander d’appeler pour vous et de faire une réservation au restaurant ou chez le coiffeur. Google souhaite également utiliser Duplex pour les centres d’appel automatisés, imaginant la possibilité de deux robots communiquant entre eux en utilisant le langage humain.

Ça a l’air prometteur, n’est-ce-pas ? Certes, mais on ne peut éviter de se poser la question de la confiance que l’on peut avoir dans un assistant virtuel qui agit en notre nom. Ces tâches de communication paraissent simples, mais elles pourraient soulever des problèmes potentiels.

Par exemple, lorsque nous parlons entre nous, nous relevons inconsciemment des indices subtils dans le ton et les attitudes de la personne, qui nous aide à réagir en conséquence. Et même en sachant cela, il est facile de vexer une personne ou de causer une dispute sans l’avoir voulu !

Mais ou se trouve la responsabilité lorsqu’un assistant virtuel dit quelque chose considéré comme offensant ou embarrassant ? Si les assistants virtuels doivent être limités dans leur communication pour ne pas utiliser de critiques ou d’ironie, est-ce votre voix qui est censurée ?

Regarder Google Duplex en action au Google I/O 2018 :

Une autre grande thématique du Google I/O comme de la WWDC d’Apple a été le « bien-être digital ». L’idée, fortement paternaliste, est que les utilisateurs ne lâcheront leur appareil que s’il le leur suggère lui-même.

Les utilisateurs peuvent définir des préférences pour ce genre de services. L’IA peut désormais nous aider à gérer notre temps et notre bien-être en plus des routines de santé, de travail et de divertissement, en fonction de ce qu’elle a appris de nos habitudes. Cela peut sembler une réelle avancée pour certains, mais personnellement, je trouve que ce niveau d’attention aux détails est un véritable cauchemar.

Bien sûr, les humains ne délègueront pas automatiquement leurs responsabilités à une IA à moins qu’ils n’y voient un réel avantage. Et des avantages, il y en aura : en termes de confort, d’efficacité, de divertissement, etc. Les avantages seront trop beaux pour y résister, et je ne suis pas du genre à m’opposer au progrès technologique. Nous embrasserons les technologies d’intelligence artificielle pour les bénéfices qu’elles nous apporteront, et ajusterons en conséquence nos attentes.

Que cela nous plaise ou non, nos sociétés s’adapteront pour donner une place à l’IA

Les thrillers classiques de science-fiction nous montrent généralement une machine super-intelligente qui devient consciente d’elle-même et se retourne contre ses créateurs. Ce genre d’IA diabolique n’est pas plus réaliste que les vampires ou les loups garous, mais nos luttes avec l’IA n’en sont pas moins réelles. Ce sont des lutes quotidiennes, un dilemme permanent entre le confort et la responsabilité dans de nombreux aspects de nos vies.

Mais derrière l’intelligence artificielle, il n’y a pas de conscience au sens où on l’entend aujourd’hui. Nous ne construisons pas des dieux dotés d’une intelligence artificielle, mais plutôt des machines auxquelles nous faisant de plus en plus confiance sans toutefois pouvoir entièrement les contrôler.

Dans le pire des cas, plus personne ne questionnera les méthodes des algorithmes, et ces débats tomberont dans l’oubli. Dans le meilleur des cas, un développement responsable permettra de laisser les véritables responsabilités dans les mains des humains.

Que pensez-vous du rôle des IA dans notre vie quotidienne ? Donnons-nous déjà de trop grandes responsabilités à certains algorithmes ?

La déresponsabilisation a commencé depuis longtemps. Qui ne s'est pas déjà entendu dire face à un problème, c'est l'informatique ! Ca permet de ne pas assumer et donc de ne rien faire.

ou peut être qu il n on plu de volanter de combattre psk imaginon que tlm quitter google . je ne pense pas que la prochaine entreprise qui la remplacera fera mieux srt si elle est gratuite et le pire sera sûrement en terme de protection de la vie privée

Pourquoi donc les gens réagissent-ils si peu ? Parce que c'est devenu une règle pour la majorité. Ils ne réagissent pas plus pour les problèmes écologiques, les décisions gouvernementales, etc. Peut être une forme de lassitude devant tant de problèmes simultanés ou un individualisme inculqué depuis plusieurs décennies ?

oui c vrai et noublient pas que il s est deja passé un truc pareil avec le véhicule de huber il a renversé un piéton et j ai pas bien suivi l affaire mais je crois que personne na etait designer comme responsable

et puis l IA des fois certaines desicions sont personnels une IAna pas note coeur ou notre cerveau elle ne reflechi pas de la meme manière , mtn si on parle de faire des calculs et des programmations et ce genre de choses d acc mais de la a repondre a nos msg et puis quoi encore ? une autre foiq ca sera le mariage ????

-

Admin

11 juil. 2018 Lien du commentaireOui, surtout à " Mr Zuckerberg" en particulier, le gourou de ses bois