Exmor, Isocell: Tout savoir des types de capteurs photo sur smartphone

Alors que les fabricants de smartphones s'empressent d'augmenter le nombre de mégapixels dans leurs appareils photo, en vantant des niveaux de zoom fantaisistes, une fonctionnalité bien plus importante des appareils photo reste pourtant trop méconnue: la taille du capteur.

Pourquoi est-ce si important pour la qualité de l'image d'un smartphone photo? La réponse dans cet article, un nouvel épisode de ma série de guides autour de la photo sur smartphone dont vous pouvez retrouver les épisodes précédents ci-dessous.

- Lire aussi: Guide photo pour smartphone: À quoi sert l'ouverture F1.7?

- Lire aussi: Smartphone photo: La sensibilité ISO et double ISO, c'est important?

Accès rapide:

- Taille du capteur en pouces: des tubes analogiques aux puces CMOS

- Zone effective du capteur: plus c'est grand, mieux c'est

- Bayer Mask & Co: on prend des couleurs

- Logiciel de l'appareil photo: L'algorithme, c'est tout

- Autofocus: PDAF, 2x2 OCL, c'est quoi

Taille du capteur en pouces: Des tubes analogiques aux puces CMOS

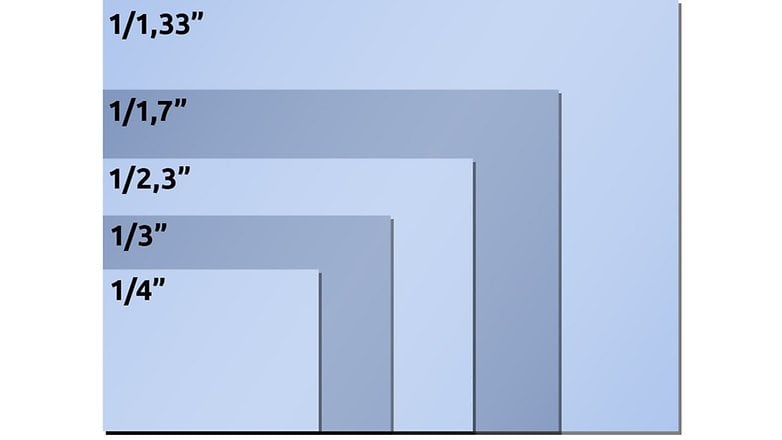

Commençons par quelques informations de base. Dans la plupart des fiches techniques des smartphones, la taille du capteur de l'appareil photo est généralement indiquée en 1/pouce: par exemple 1/1,72 pouce ou 1/2 pouce. Malheureusement, cette taille ne correspond pas à la taille réelle du capteur de votre smartphone.

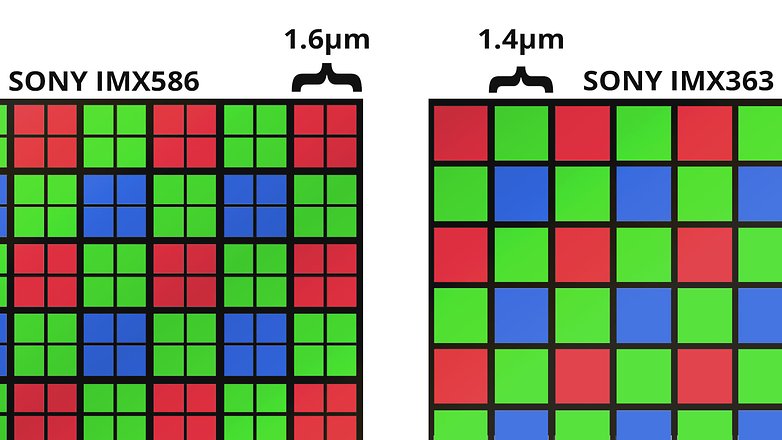

Jetons un coup d'œil à la fiche technique de l'IMX586 de Sony: un demi-pouce de ce capteur correspondrait en fait à 1,27 centimètre. La taille réelle de l'IMX586 de Sony n'a pas grand chose à voir avec cela, cependant.

Si nous multiplions la taille de 0,8 micron de pixels par la résolution horizontale de 8000 pixels, nous obtenons seulement 6,4 millimètres, soit environ la moitié du nombre. Si nous mesurons d'abord l'horizontale et que nous appliquons ensuite le théorème de Pythagore pour obtenir la mesure diagonale, nous obtenons 8,0 millimètres. Même cela est loin d'être suffisant.

Et voici le nœud du problème: Les personnalisations ont été introduites il y a environ un demi-siècle, lorsque les caméras vidéo utilisaient encore des tubes à vide comme convertisseurs d'images. Les services marketing conservent encore avec beaucoup de vigueur le rapport approximatif entre la surface photosensible et le diamètre du tube de l'époque.

Si vous voulez connaître la taille réelle d'un capteur d'images, consultez la fiche technique du fabricant ou la page détaillée de Wikipedia sur les tailles des capteurs d'images. Vous pouvez aussi suivre l'exemple ci-dessus et multiplier la taille en pixels par la résolution horizontale ou verticale.

Zone effective du capteur: Plus c'est grand, mieux c'est

Pourquoi la taille du capteur est-elle si importante? Imaginez la quantité de lumière qui traverse l'objectif et arrive sur le capteur comme si la pluie tombait du ciel. Vous avez maintenant un dixième de seconde pour estimer la quantité d'eau qui tombe actuellement.

- Avec un verre à shooter, ce sera relativement difficile pour vous, mais en un dixième de seconde, sous une forte pluie, peut-être que quelques gouttes tomberont dans le verre - avec peu de pluie ou avec un peu de malchance, peut-être pas du tout. Votre estimation sera très imprécise dans un cas comme dans l'autre.

- Imaginez maintenant que vous avez une pataugeoire pour effectuer la même tâche. Vous pouvez ainsi facilement attraper quelques centaines à quelques milliers de gouttes de pluie, et grâce à la surface, vous pouvez faire une estimation plus précise de la quantité de pluie.

Tout comme pour le verre à shooter, la pataugeoire et la pluie, il en va de même pour la taille des capteurs et la quantité de lumière, qu'elle soit forte ou faible. Plus il fait sombre, moins les convertisseurs de lumière captent de photons - et moins le résultat de la mesure est précis. Ces imprécisions se manifestent ensuite par des erreurs telles que le bruit de l'image, les couleurs, etc.

Certes, la différence entre les capteurs d'images des smartphones n'est pas aussi grande que celle qui existe entre un verre à shooter et une pataugeoire. Mais l'IMX586 de Sony mentionné ci-dessus dans le téléobjectif du Samsung Galaxy S20 Ultra est environ quatre fois plus grand en termes de taille de surface que le capteur de 1/4,4 pouces du téléobjectif du Xiaomi Mi Note 10.

Quand il s'agit de zoomer: Le fait que le constructeur inscrive "x100" ou "x10" équivaut en quelque sorte aux chiffres indiqués par le compteur de vitesse d'une voiture. Une VW Golf avec un compteur de vitesse qui atteint 360 km/h n'ira toujours pas plus vite qu'une Ferrari. Toutefois, c'est un sujet qui devrait être abordé dans un autre article.

Bayer Mask & Co: on prend des couleurs

Revenons sur l'analogie de l'eau vue d'en haut. Si nous placions maintenant une grille de 4000 par 3000 seaux sur une prairie, nous pourrions déterminer avec une résolution de 12 mégapixels la quantité de pluie et probablement prendre une sorte d'image de la saturation en eau du nuage de pluie aérien.

Cependant, si un capteur d'images de 12 mégapixels devait capturer la quantité de lumière avec ses pièges à photons de 4000 sur 3000, la photo résultante serait en noir et blanc - car nous n'avons mesuré que la quantité absolue de lumière. Nous ne pouvons distinguer ni les couleurs ni la taille des gouttes de pluie qui tombent. Comment le noir et blanc finit-il par devenir une photo couleur?

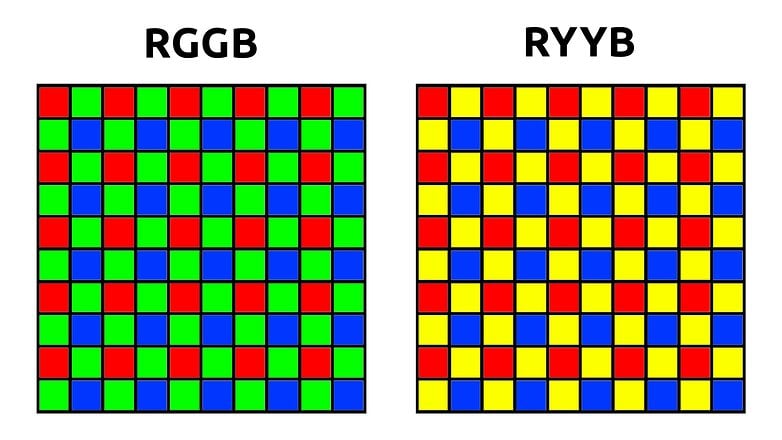

L'astuce consiste à placer un masque de couleur sur le capteur, ce qu'on appelle la matrice Bayer. Cela permet de s'assurer que seule la lumière rouge, bleue ou verte atteint les pixels. Avec la matrice Bayer classique qui a une disposition RGGB, un capteur de 12 mégapixels possède alors six millions de pixels verts et trois millions de pixels rouges et bleus chacun.

Afin de générer une image de douze millions de pixels RVB à partir de ces données, le traitement de l'image utilise généralement les pixels verts pour le démosaïquage. En utilisant les pixels rouges et bleus environnants, l'algorithme calcule ensuite la valeur RVB de ces pixels - ce qui est une explication très simplifiée.

En pratique, les algorithmes de démosaïquage sont beaucoup plus intelligents, par exemple, pour éviter les franges de couleur sur les bords nets, puis le même principe s'applique aux pixels rouges et bleus, où une photo colorée finit par se retrouver dans la mémoire interne de votre smartphone.

Quadruple Bayer et Tetracell: le pixel binning

Qu'il s'agisse de 48, 64 ou 108 mégapixels, la plupart des capteurs actuels à très haute résolution des smartphones ont une chose en commun: le pixel binning. Alors que le capteur lui-même possède 108 millions de seaux d'eau ou de capteurs de lumière, le masque de Bayer qui se trouve au-dessus a une résolution quatre fois plus faible. Il y a donc quatre pixels sous chaque filtre de couleur.

Bien sûr, cela a l'air incroyablement bien quand c'est spécifié sur la fiche technique. Un capteur de 48 mégapixels! 108 mégapixels! Ce ne sont que des chiffres gonflés pour titiller l'imagination. Et quand il fait nuit, les minuscules pixels peuvent être combinés pour former de grands superpixels tout en offrant de superbes photos de nuit.

Paradoxalement, cependant, de nombreux smartphones bon marché n'offrent pas du tout la possibilité de prendre des photos de 48 mégapixels - ou même de fournir une qualité d'image inférieure en comparaison directe lorsqu'ils sont en mode 12 mégapixels.

Dans tous les cas que je connais, les smartphones sont tellement plus lents lorsqu'ils prennent des photos avec une résolution maximale que la légère amélioration de la qualité du cliché ne vaut tout simplement pas le temps passé à le prendre. D'autant plus que 12, 16 ou 27 mégapixels sont tout à fait suffisants pour un usage quotidien et n'épuisent pas la mémoire de votre appareil aussi rapidement.

La plupart de la propagande marketing qui pousse des dizaines de mégapixels peut être ignorée. Mais dans la pratique, les capteurs haute résolution sont en fait plus grands - et la qualité de l'image finit par en tirer des avantages notables.

Le capteur SuperSpectrum de Huawei: le même en jaune

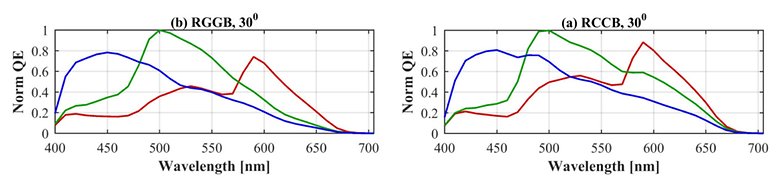

Il existe également quelques dérivés de la matrice de Bayer, l'exemple le plus marquant étant la matrice RYYB de Huawei (voir le graphique ci-dessus), dans laquelle le spectre d'absorption des pixels verts est décalé vers le jaune. Cela présente l'avantage - du moins sur le papier - d'absorber plus de lumière et de faire arriver plus de photons au capteur dans l'obscurité.

Cependant, les longueurs d'onde mesurées par le capteur ne sont plus aussi uniformément réparties dans le spectre et aussi clairement séparées les unes des autres que celles d'un capteur RGGB. Afin de maintenir des niveaux de reproduction des couleurs précis, les exigences imposées aux algorithmes, qui doivent ensuite interpoler les valeurs des couleurs RVB, devront augmenter de manière correspondante.

Il n'est pas possible de prédire quelle approche produira de meilleures photos au final. Cela dépend en grande partie des tests pratiques et de laboratoire qui tendent à prouver que l'une ou l'autre technologie est "meilleure".

En matière de photo: les algorithmes font tout

Enfin, je voudrais dire quelques mots sur les algorithmes. Cela est d'autant plus important à l'ère de la photographie numérique, où le concept de photographie devient flou. Une image composée de douze photographies individuelles est-elle vraiment une photographie au sens premier du terme?

Ce qui est certain, c'est que l'influence des algorithmes de traitement de l'image est bien plus importante que le nombre de bits dans une zone de capteur. Oui, une différence de surface par un facteur de deux fait une grande différence.

Mais un bon algorithme représente aussi beaucoup. Sony, le leader mondial du marché des capteurs, en est un bon exemple. Bien que la plupart des capteurs d'images (du moins sur le plan technologique) viennent du Japon, les smartphones Xperia ont toujours été à la traîne de la concurrence en termes de qualité d'image.

À ce stade, je voudrais faire une remarque sur la sensibilité de l'ISO. Comme je l'explique dans l'autre épisode de cette série lié en début d'article, ne vous laissez jamais impressionner par les chiffres de l'ISO. Les capteurs d'images ont une seule sensibilité ISO native dans presque tous les cas*, qui est très rarement mentionnée dans les fiches techniques.

Les valeurs ISO qu'on règle pendant le processus de prise de vue en mode manuel ou pro, par exemple, ressemblent plutôt à un gain - un degré de "contrôle de la luminosité". La "longueur" de l'échelle de ce contrôle de la luminosité peut être définie librement, de sorte qu'écrire une valeur comme 409 600 ISO dans la fiche technique a autant de sens qu'avec une VW Golf... eh bien, ne nous aventurons pas sur cette voie.

*Il existe en fait quelques capteurs à double ISO avec deux sensibilités natives sur le marché des appareils photo, comme le Sony IMX689 dans l'Oppo Find X2 Pro, du moins c'est ce que prétend Oppo. Sinon, ce dispositif est plus susceptible d'être trouvé dans des caméras professionnelles comme la BMPCC 6K.

Autofocus: PDAF, 2x2 OCL, c'est quoi?

Une petite digression à la fin, qui est directement liée au capteur d'image: tout le sujet de l'autofocus. Dans le passé, les smartphones déterminaient la mise au point correcte grâce à l'autofocus par contraste. Il s'agit d'une détection de bord lente et intensive en calcul.

La plupart des capteurs d'images ont désormais intégré un autofocus à comparaison de phase, également connu sous le nom de PDAF. Le PDAF comporte des pixels autofocus spéciaux intégrés au capteur, qui sont divisés en deux moitiés et comparent les phases de la lumière incidente et calculent la distance au sujet.

L'inconvénient de cette technologie est que le capteur d'image est "aveugle" à ces endroits - et cet angle mort de la mise au point peut affecter jusqu'à trois pour cent de la zone, selon le capteur.

Juste un rappel: moins de surface se traduit par moins de lumière/eau et par conséquent, une qualité d'image moindre. De plus, les algorithmes doivent retoucher ces défauts tout comme votre cerveau doit comprendre le "blind spot."

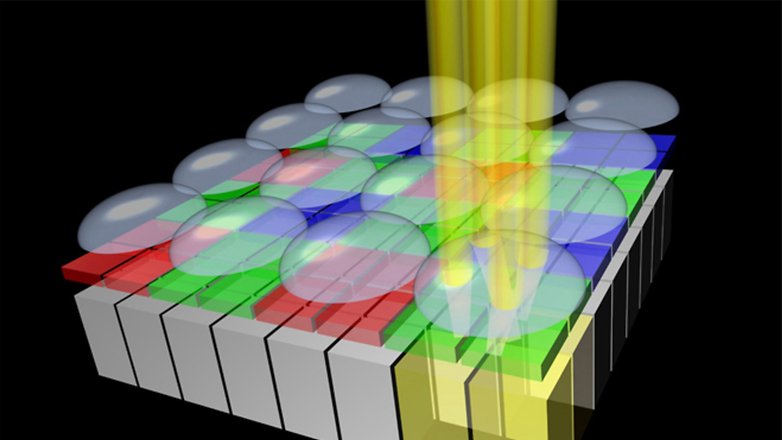

Cependant, il existe une approche plus élégante qui ne rend pas les pixels inutilisables. Les micro-lentilles déjà présentes sur le capteur sont réparties sur plusieurs pixels par endroits. Sony, par exemple, appelle cela 2x2 OCL ou 2x1 OCL, selon que les micro-lentilles combinent quatre ou deux pixels.

Nous consacrerons bientôt un article distinct et plus détaillé à l'autofocus ainsi qu'aux critères auxquels il faut faire attention avant d'acheter un nouveau smartphone photo? D'ailleurs, n'hésitez pas à nous suggérer sur quels sujets liés à la photo sur smartphones vous aimeriez avoir des guides. J'attends avec impatience vos commentaires!

À lire également sur AndroidPIT France: