L'IA n'est pas impartiale, elle a les même défauts que les humains !

Le discours autour de l'intelligence artificielle tombe souvent dans des extrêmes : soit en exagérant ses aspects positifs et ses capacités, soit en craignant la disparition de notre monde tel que nous le connaissons avec des scénarios dignes de Terminator. Nous ne devrions cependant pas laisser les vrais problèmes entourant l'IA se perdre dans cette mer de sensationnalisme. Un problème courant que nous constatons déjà est que l'IA est loin d'être neutre. Elle peut discriminer parce qu'elle hérite souvent de préjugés humains.

L'IA peut analyser de grandes quantités de données et faire des prédictions basées uniquement sur des faits concrets. Du moins, c'est ce qu'on aimerait penser. La vérité est, cependant, que la plupart des données de formation que les algorithmes d'apprentissage machine utilisent aujourd'hui sont construites par des humains ou au moins avec l'implication humaine. Et comme la plupart des algorithmes actuels ne sont pas open source, nous ne pouvons pas savoir dans quelle mesure l'information reçue par un IA est complète et si toutes les variables ont été couvertes.

Problèmes existants et futurs

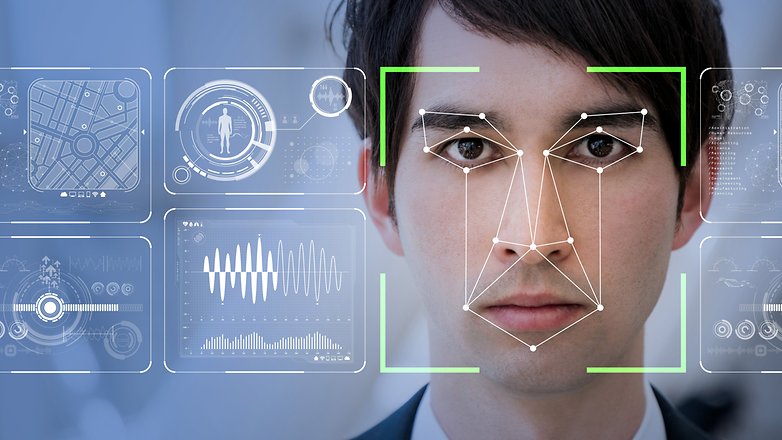

Pourquoi est-ce un problème ? Parce que l'intelligence artificielle n'est pas seulement la conservation de vos recommandations Netflix ou de vos flux de médias sociaux, elle prend de plus en plus de décisions qui peuvent avoir un impact significatif sur votre vie. Des algorithmes d'apprentissage automatique sont utilisés pour parcourir les curriculum vitae et sélectionner les candidats appropriés, pour prédire les probabilités de récidive dans des affaires judiciaires et certains tentent même de repérer de futurs terroristes en fonction de leurs traits faciaux.

Il y a déjà eu des cas qui montrent comment l'IA peut hériter des préjugés humains et marginaliser davantage les minorités ou les groupes vulnérables. L'un des exemples les plus connus est un outil expérimental d'embauche en Amazonie qui discrimine les femmes. L'algorithme évaluait les candidats de une à cinq étoiles et était censé sélectionner ceux qui convenaient le mieux au poste. Toutefois, il a commencé à faire preuve de discrimination à l'égard des femmes, parce que les données qu'il utilisait pour sa formation contenaient principalement des CV de candidats masculins. Il a donc conclu que les femmes n'étaient pas souhaitables et a pénalisé les demandes comportant le mot " femmes ".

Une étude de Pro Publica, en revanche, a découvert que COMPAS - un algorithme censé prédire la récidive - était raciste. Leur analyse a révélé que les accusés noirs étaient beaucoup plus susceptibles que les accusés blancs d'être jugés à tort comme présentant un risque plus élevé de récidive.

De tels cas prouvent que la transparence et la possibilité d'expliquer le fonctionnement exact de l'IA sont d'une importance capitale. Lorsqu'une machine prend des décisions concernant l'avenir d'une personne, nous devons savoir sur quoi elles sont basées. Dans le cas de COMPAS, il utilisait des données sur l'incarcération. Cependant, se fier aux données historiques peut poser des problèmes, les machines rencontreront des modèles historiques basés sur des préjugés fondés sur le sexe, la race et autres. Ce n'est pas parce qu'historiquement, par exemple, il y a peut-être eu moins de candidats masculins à des postes d'infirmières, que les hommes sont moins qualifiés ou moins méritants.

Il y a aussi des cas où l'intelligence artificielle peut avoir raison, mais pour les mauvaises raisons. Selon le Washington Post, "un professeur de l'Université de Washington a partagé l'exemple d'un collègue qui a formé un système informatique pour faire la différence entre les chiens et les loups. Des tests ont prouvé que le système était précis à près de 100 %. Mais il s'est avéré que l'ordinateur a réussi parce qu'il a appris à chercher de la neige dans le fond des photos. Toutes les photos de loups ont été prises dans la neige".

Enfin, nous devons discuter des cas où l'IA est utilisée en combinaison avec des données scientifiques douteuses. Une startup israélienne appelée Faception prétend être capable d'identifier des terroristes potentiels par leurs traits physiques à l'aide de l'intelligence artificielle. Plus inquiétant encore, selon le Washington Post, ils ont déjà signé un contrat avec une agence de sécurité locale.

Le PDG de l'entreprise, Shai Gilboa, affirme que "notre personnalité est déterminée par notre ADN et se reflète dans notre visage. C'est une sorte de signal." Faception utilise 15 classificateurs qui peuvent prétendument identifier certains traits avec une précision de 80%. Cependant, si vous vous retrouvez dans les 20 %, ce qui pourrait être considéré à tort comme un terroriste ou un pédophile. Et ce n'est pas tout, la science sur laquelle s'appuie l'entreprise est très discutable. Alexander Todorov, professeur de psychologie à Princeton, a déclaré au Post que "les preuves de l'exactitude de ces jugements sont extrêmement faibles". L'entreprise refuse également de rendre publics ses classificateurs. Il n'est pas difficile de voir comment cela peut avoir des conséquences désastreuses.

Solutions possibles

IBM est l'une des entreprises qui s'attaque ouvertement au problème de la partialité de l'intelligence artificielle. Elle a mis au point une nouvelle méthodologie visant à réduire la discrimination existante dans un ensemble de données. L'objectif est qu'une personne ait les mêmes chances de "recevoir une décision favorable", pour un prêt par exemple, indépendamment de son appartenance à un groupe "protégé" ou "non protégé".

Cependant, Francesca Rossi, chercheuse chez IBM, a également mis l'accent sur les changements que l'industrie elle-même doit apporter. Selon elle, le développement de l'intelligence artificielle doit se faire dans des environnements multidisciplinaires et avec une approche multiculturelle. Elle croit aussi que plus nous en apprenons sur les préjugés liés à l'IA, plus nous en apprenons sur les nôtres.

Francesca Rossi est également très optimiste - elle affirme que la partialité de l'IA peut être éliminée dans les cinq prochaines années. Pourtant, ce n'est pas facile d'être d'accord avec elle. Un changement culturel important doit d'abord se produire dans l'industrie de la technologie. Néanmoins, l'approche multidisciplinaire qu'elle propose pourrait favoriser ce changement. C'est aussi un besoin criant, de nombreux développeurs et chercheurs n'ont pas reçu de formation officielle en éthique ou dans des domaines connexes.

Une autre étape vers la résolution du problème du biais de l'IA pourrait être sa " démocratisation ", c'est-à-dire mettre à la disposition du public des algorithmes afin qu'il puisse mieux les étudier, les comprendre et les utiliser. Des entreprises comme OpenAI sont déjà sur cette voie. Toutefois, ceux qui protègent leur propriété intellectuelle ne suivront probablement pas cette tendance.

Comme vous pouvez le constater, il n'y a pas de réponse facile. Une chose est certaine, cependant : nous ne devrions pas faire aveuglément confiance à la technologie et nous attendre à ce qu'elle résolve tous nos problèmes. Comme toute autre chose, rien ne sort du néant. C'est un produit de la société et, par conséquent, elle hérite de tous nos préjugés et idées préconçues.

Que pensez-vous de ce sujet ? Faites-le nous savoir dans les commentaires.

L'IA c'est juste du "Si... Alors... Sinon" etc dont les algorithmes sont programmés par des humains.

Tant que l'algo est bienséant alors ça va, mais si les humains codent avec des intentions négatives c'est là que ça met l'humanité en danger car la finalité c'est quoi ? LE POUVOIR

-

Admin

6 févr. 2019 Lien du commentaireSi tu n'est pas blanc alors tu es noir

?Non métisse mais ça n'existe pas.

Ou asiat ?

-

Admin

6 févr. 2019 Lien du commentaireÇa n'existe pas non plus

l'IA n'existe pas...ou alors elle existe ds le même esprit que ceux qui croient en dieu! ce n'est qu'une création humaine.

Le téléphone que j'ai entre les mains est une création humaine, et pourtant il existe bien…

L'esprit et la chose ne sont très comparables, il me semble...

Par contre le performatif qui fait exister par les paroles prononcées, ça existe depuis le langage !

-

Admin

5 févr. 2019 Lien du commentaireSuper, tout se travaille et cet argent pour créer la première Me Michu avec intelligence artificielle

?Et pour le coup ça fait pas si Intelligent quand c'est artificielle

Si j'avais à résumer très rapidement cet article, fort bien fait au demeurant et remplit d'infos peu connues du public, je dirais les choses ainsi :

L'IA n'en est qu'à ses balbutiements et on découvre des biais certes très gênants mais avec la pratique qui se répand nous serons gagnants dans un avenir (que l'on se garde bien de préciser) nous les êtres humains imparfaits du XXIème siècle, toujours prêts à découvrir les merveilles que la technologie du numérique nous réserve.

"Tout va très bien Madame la Marquise..."

Seulement, très curieusement un fait presque anodin, mais majeur à mon idée, est scrupuleusement ignoré même s'il devrait se voir comme un nez au milieu de la figure.

A qui appartient ces algorithmes et ses procédures destinées à mieux gérer et gouverner le monde ?

Au domaine privé, le plus puissant qui puisse exister et déjà déjà détenteur d'un pouvoir obtenu sans l'assentiment législatif d'aucuns textes ou recommandations (aucun des GAFAM n'existaient il y a plus de 30 ans)

Quelles sont les lois qui régentent ce domaine nouveau mais dont les prémices remontent aux années 50 (sous le nom de cybernétique) ?

Aucune.

Vu les conséquences imaginables sur les différentes sociétés comme il y est fait allusion dans l'article et les directions dirigistes, autoritaires ou dictatoriales qui deviennent chaque jour plus évidentes dans un grand nombre de pays, souvent les plus influents, des gouvernements établis, l'avenir s'annonce pas forcément aussi radieux que voudrait le laisser croire l'article.

S'il avait été inspiré (et seulement inspiré...) par ceux qui pensent "tirer les marrons du feu, il n'aurait guère été conçu différemment...

Un point supplémentaire qui m'encourage à penser ainsi, l'absence de sources citées.

Un pur hasard...

Moi complotiste ?

Avec des arguments comme ceux-là, ce n'est pas vraiment nécessaire ?